- Accueil

- Cyber stabilité

- Opérations militaires et IA : quelle place pour l’humain dans la boucle décisionnelle ?

Opérations militaires et IA : quelle place pour l’humain dans la boucle décisionnelle ?

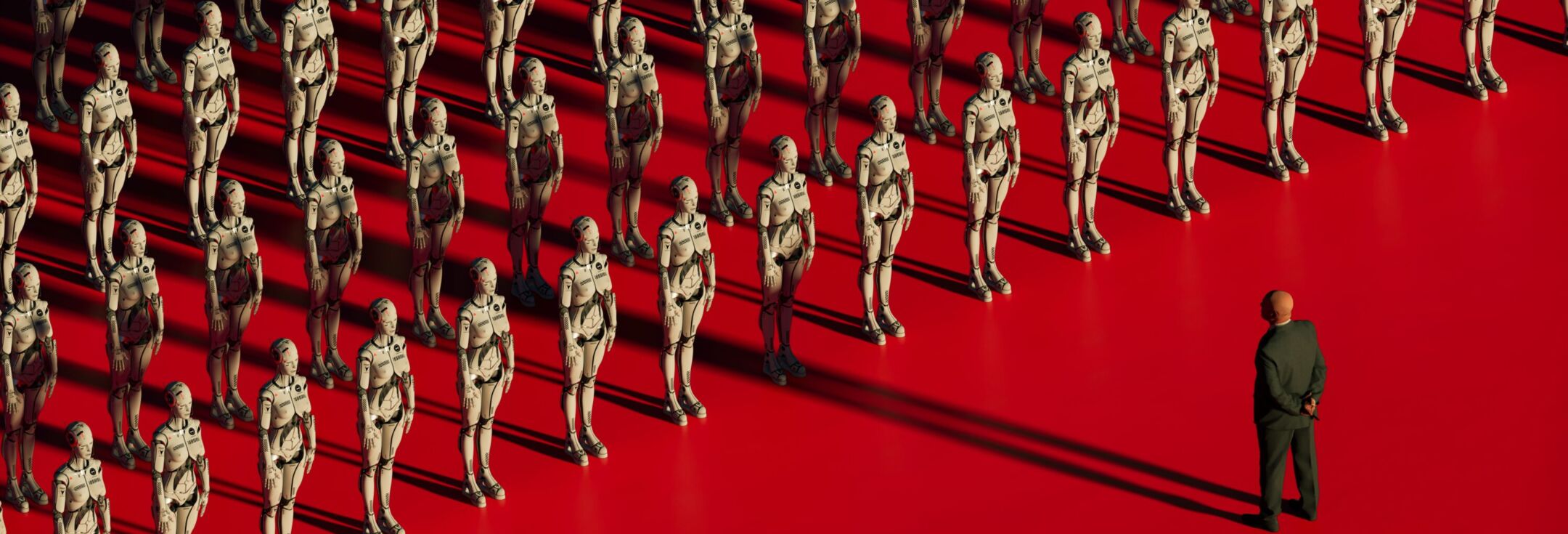

C’est à ces questions qu’ont tenté de répondre les participants à la table ronde organisée au Forum InCYBER à Lille, sur le thème « Cyberdéfense, opérations militaires et IA : quelle place pour l’homme dans la boucle décisionnelle ? » En croisant les regards militaires, civils et éthiques, les intervenants dressent un constat lucide : l’IA ne remplace pas l’homme dans la “prise de décision”, mais elle redéfinit profondément sa position.

Une boucle décisionnelle accélérée, concentrée… et déshumanisée ?

« Notre mission première est de faire la guerre, et notre objectif, de la gagner », pose d’emblée le colonel Patrice Tromparent pour ouvrir le débat. Et dans l’accomplissement de cette mission, le facteur temps est un levier stratégique majeur. Trop lent, on subit. Trop rapide, on commet des erreurs. Tout l’enjeu est de “boucler plus vite que l’adversaire” la fameuse boucle OODA — Observer, Orienter, Décider, Agir.

L’intelligence artificielle intervient ainsi avant tout comme un multiplicateur de vitesse : elle réduit les délais d’analyse, suggère des priorités et propose des options de traitement des objectifs en temps réel. “Là où il fallait 2000 hommes en Afghanistan, il n’en faut plus que 20 aujourd’hui” explique le colonel Tromparent. En bref, elle intervient à toutes les étapes de la boucle décisionnelle et elle la concentre fortement. L’exemple du programme américain Maven est représentatif de cette dynamique : « À partir de données hétérogènes — imagerie satellitaire, interceptions, plans de situation — l’IA propose automatiquement des cibles à l’humain. Il les valide puis elle les transmet aux vecteurs les plus aptes à engager » explique le colonel.

L’IA, ici, ne remplace pas l’humain, mais elle redessine clairement sa position dans le processus de prise de décision, en le resserrant autour d’un centre de gravité algorithmique. C’est toujours l’homme qui “décide”, mais dans un cadre pré-calibré en amont par la machine.

Les doctrines occidentales affirment toutes la nécessité de maintenir “l’homme dans la boucle” (in the loop). Mais ce principe reste flou. Selon Éric Salobir, la place de l’humain dans la boucle décisionnelle dépend moins d’un mécanisme binaire que d’une combinaison de facteurs : le type de mission, le contexte opérationnel, la nature de la décision (informatique, opérationnelle, létale), et le niveau de responsabilité engagé. David Byrne, de l’Agence Européenne de Défense présente trois configurations co-existantes :

- In the loop : l’humain décide, la machine assiste.

- On the loop : l’humain supervise, mais n’intervient que sur exception.

- Out of the loop : la machine agit seule.

Mais même dans la configuration in the loop, prônée en Occident, la place de l’algorithme dans la prise de décision se pose : “Si la machine dit que telle solution a 90 % de chances de succès et que l’autre solution en a seulement 10 %, quel chef militaire choisirait les 10 % ?” interroge le colonel Tromparent. Le principal danger n’est pas que l’IA prenne le pouvoir. Le risque majeur, plus banal, c’est que l’humain se mette en retrait, par habitude et par excès de confiance.

Une responsabilité humaine fragilisée par la technicité

La question de la responsabilité dans la prise de décision s’en trouve alors fortement impactée. Les chaînes de traitement, dans une opération assistée par IA, impliquent de multiples acteurs et couches d’analyse : systèmes d’acquisition, bases de données, interfaces humaines, algorithmes de priorisation, outils de visualisation tactique. En cas d’erreur — frappe sur une mauvaise cible, estimation erronée, mauvais calibrage de l’action, dommages collatéraux — qui assume la responsabilité ? L’opérateur, le développeur, le commandement ? Dans tous les cas, « la responsabilité ne peut être que humaine », rappelle Eric Salobir. « Aucune machine ne sera jamais convoquée devant un conseil de guerre. »

Au cours du débat, trois fragilités intrinsèques à l’usage l’IA militaire se dessinent :

La première, structurelle, tient aux biais de conception. Une IA militaire n’est jamais neutre : elle apprend à partir de données passées, dans un environnement particulier. « Les jeux de données ne reflètent pas forcément les nouvelles réalités du champ de bataille, notamment en contexte urbain ou asymétrique », souligne Eric Salobir. Cela expose les modèles à des erreurs de généralisation, particulièrement sensibles dans des contextes mouvants, ou face à des adversaires non conventionnels.

Deuxième faille : l’effet “boîte noire”. Plus un modèle est performant, notamment en deep learning, moins il est lisible. Cela pose un problème fondamental en environnement militaire : si l’on ne peut pas expliquer pourquoi une cible a été désignée, il devient très difficile d’en justifier l’atteinte, en particulier dans un cadre légal ou diplomatique.

Enfin, la manipulabilité : les systèmes IA peuvent être volontairement trompés. Des attaques dites “adversariales” — consistant à introduire des perturbations discrètes dans les entrées du système — peuvent générer des erreurs de classification majeures. Un simple artefact visuel peut suffire à faire passer un véhicule blindé pour un camion civil, ou à masquer la présence d’un combattant.

La doctrine : point de bascule stratégique

Les panélistes s’accordent à dire que les forces occidentales, dans leur grande majorité, s’imposent des garde-fous stricts : supervision humaine obligatoire, respect du droit international humanitaire, traçabilité des décisions, interdiction des frappes létales sans validation. Cette rigueur est présentée à la fois comme un choix politique, une exigence éthique et une condition d’acceptabilité sociale. Le colonel Patrice Tromparent le souligne : « Il ne s’agit pas de descendre au niveau d’un adversaire sans morale. Il y a d’autres manières de gagner. » Mais cette rigueur peut devenir un handicap lorsque l’adversaire, lui, ne s’impose aucune de ces limites.

Des États ou des groupes armés non étatiques exploitent déjà des systèmes autonomes sans intervention humaine explicite — drones kamikazes, essaims automatisés, attaques cognitives ou cyber offensives. « Forcément, on préfère envoyer des machines plutôt que des soldats, surtout face à celles d’un adversaire qui, lui, n’hésitera pas à les utiliser », souligne le colonel Tromparent. Comme à l’époque du débat sur l’arme sous-marine — rappelle Henri Schricke —un excès de retenue peut coûter la guerre. D’où l’impératif de connaître les usages adverses, y compris les plus sombres, pour ne pas être pris au dépourvu. Il ne s’agit pas de renoncer à ses principes, mais de ne pas laisser le monopole de l’innovation aux puissances qui s’affranchissent des règles.

À mesure que l’IA s’impose dans les opérations militaires, une équation délicate se dessine entre vitesse et discernement, efficacité et responsabilité, automatisation et contrôle humain. L’homme doit “rester au centre de la décision” — non pas comme une simple caution morale, mais comme acteur éclairé et formé, capable d’assumer ses choix et de comprendre les limites des systèmes.

« La vraie asymétrie, ce n’est pas la technologie. C’est la doctrine. » La formule d’Henri Schricke résume un des enjeux majeurs de l’intégration de l’IA dans la guerre : ce qui différencie les puissances n’est pas tant ce qu’elles peuvent faire que ce qu’elles s’autorisent à faire avec l’IA.

la newsletter

la newsletter