- Accueil

- Gestion des risques

- Deepfakes : 2024, l’année de tous les dangers

Deepfakes : 2024, l’année de tous les dangers

Cette année, la conjonction de deux forces va créer des risques majeurs pour la démocratie dans le monde. La moitié de la population mondiale sera appelée aux urnes et les outils d’intelligence artificielle générative (IAG) atteindront des performances spectaculaires. La possibilité de créer, via ces mêmes IAG, des fake news pendant ces élections sera mise à profit par beaucoup d’acteurs malveillants. Faut-il s’en inquiéter ? Oui.

2024 sera une année exceptionnelle durant laquelle des élections vont avoir lieu dans de nombreux pays, en rose sur cette carte. États-Unis, Inde, Europe, Afrique du Sud, Mexique : ils font partie des pays les plus peuplés du monde et les résultats de ces élections auront des conséquences majeures sur la situation politique dans le monde, en 2025.

Si l’on met de côté les pays où le résultat des votes suscite peu de doute, il reste plusieurs milliards de personnes qui vivent dans des pays raisonnablement démocratiques, où leur vote compte. Des premières actions pour tenter d’influencer les votes ont eu lieu pendant les élections présidentielles américaines de 2016 et 2020. C’était la préhistoire, avant l’arrivée de l’IAG. Cette année, tous les outils d’IAG sont disponibles pour rendre les actions de déstabilisation beaucoup plus efficaces.

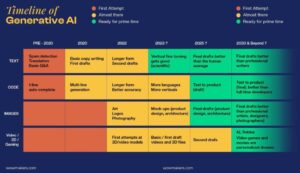

Comme le montre ce tableau, la capacité des outils d’IAG pour créer des contenus a fait des progrès spectaculaires depuis l’arrivée de ChatGPT 3, en novembre 2022, et dans tous les domaines : texte, images, sons et voix, vidéos.

Je pronostique que les trois médias qui seront le plus utilisés en 2024 pour influencer les élections seront la voix, la photo et la vidéo.

Élections + IAG : premiers exemples de deepfakes

Aujourd’hui, le clonage de la voix est très facile. Il suffit d’obtenir quelques secondes d’échantillons de la voix à copier pour le produire. C’est ce que l’on peut lire dans cet article qui donne des exemples de clonage avec deux échantillons de voix, de dix secondes et trente secondes.

On en a eu un premier exemple d’usage aux États-Unis lors des primaires démocrates dans le New Hampshire, en janvier 2024. La voix du président américain Joe Biden a été utilisée de manière frauduleuse pour des appels téléphoniques automatiques, demandant aux électeurs de ne pas voter.

Dans le domaine de la vidéo, les solutions sont encore imparfaites, mais progressent tous les mois. On en a eu un premier exemple en France en décembre 2023: la députée EELV Marie-Charlotte Garin a publié sur X-Twitter une fausse vidéo d’Emmanuel Macron.

Les élections au Pakistan ont montré une autre facette de cette utilisation de l’IAG en politique. Le candidat Imran Khan était emprisonné pendant la campagne électorale. Des textes sortis de prison par ses avocats ont permis de créer des vidéos sur YouTube, où on le voit présenter ses idées. Efficace ? Déjouant tous les pronostics, il est arrivé en tête le 8 février 2024 (jour des élections législatives) et a publié ce discours de victoire sur YouTube. En regardant cette vidéo, n’oubliez pas qu’il est toujours en prison.

Élections + IAG : peut-on se protéger des deepfakes ?

Tous les acteurs sérieux de l’IAG sont conscients des dangers et travaillent pour apporter des solutions permettant d’identifier et de signaler les deepfakes. De nombreuses solutions sont proposées, mais aucune ne prétend être efficace à 100%. Dans cet article du média américain NBC, on y lit qu’il est facile de détecter les deepfakes vocaux. On y apprend que Reality Defender, qui fonctionne aussi pour les vidéos, est l’un des outils les plus performants en la matière.

De son côté, Google a développé SynthID. Il s’agit d’une technologie permettant d’introduire des filigranes dans les images et les audio (watermark en anglais), invisibles pour les humains mais détectables par logiciel. SynthID est encore en version beta et n’est pas disponible dans tous les pays. Elle reste, à l’heure actuelle, l’une des approches la plus prometteuse à moyen terme.

Espérons qu’elle sera proposée en Open Source pour que la majorité des fournisseurs d’outils d’IAG puisse l’utiliser. Ce qui n’est pas encore le cas.

Midjourney, l’un des leaders pour la création d’images, a pris une décision drastique en février 2024 : interdire la création de photos avec Joe Biden et Donald Trump, jusqu’à fin 2024. Motif : éviter la création de photos similaires à celle-ci.

la newsletter

la newsletter

![Image Contenus intimes et IA : que faire face à la déferlante des [contenus abusifs ?]](https://incyber.org//wp-content/uploads/2024/04/incyber-news-cybersecurite-cybersecurity-dark-content-web-885x690.jpg)

![Image L’IA en [cyber threat intelligence] : un apport contrasté](https://incyber.org//wp-content/uploads/2024/03/incyber-news-artifical-intelligence-cybersecurite-cybersecurity-885x690.jpg)

![Image [Vie privée et protection de l’enfance :] comment trouver le juste équilibre face aux contenus sexuels déviants ?](https://incyber.org//wp-content/uploads/2024/04/incyber-news-cybersecurite-cybersecurity-child-protection-2024-885x690.jpg)